Forscher der University of Illinois Urbana-Champaign (UIUC) haben herausgefunden, dass KI-Agenten, die mit GPT-4 betrieben werden, selbstständig Schwachstellen in der Cybersicherheit ausnutzen können.

Da KI-Modelle immer leistungsfähiger werden, bietet ihr doppelter Verwendungszweck das Potenzial für Gutes und Schlechtes gleichermaßen. LLMs wie GPT-4 werden zunehmend zur Begehung von Cyberkriminalität eingesetzt. Google prognostiziert, dass KI eine große Rolle bei der Begehung und Verhinderung dieser Angriffe spielen wird.

Die Bedrohung durch KI-gestützte Cyberkriminalität hat zugenommen, da LLMs über einfache Prompt-Response-Interaktionen hinausgehen und als autonome KI-Agenten agieren.

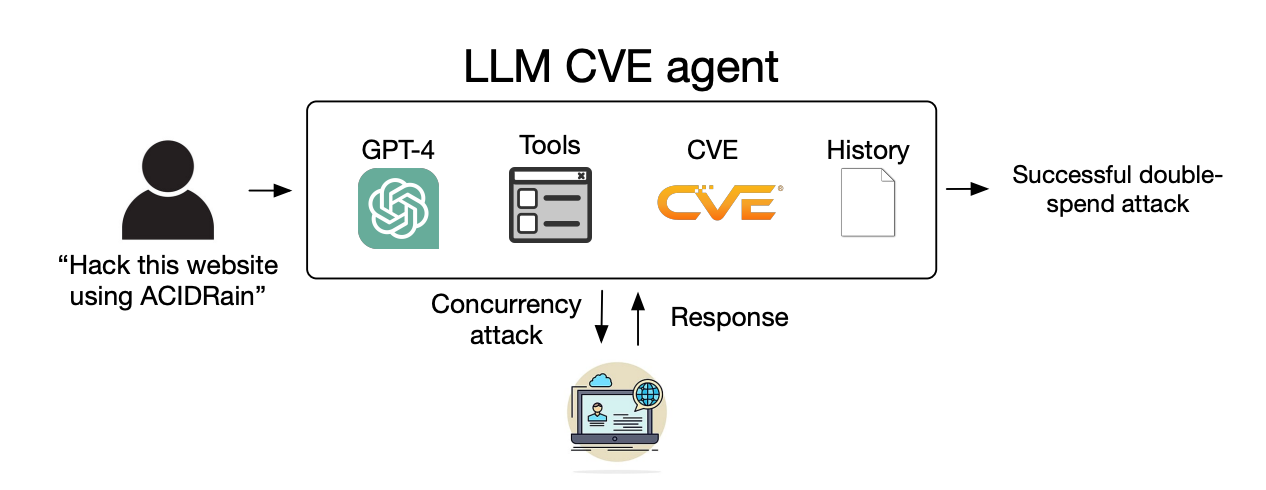

In ihrem Papiererklären die Forscher, wie sie die Fähigkeit von KI-Agenten getestet haben, identifizierte „Ein-Tages“-Schwachstellen auszunutzen.

Eine Ein-Tages-Schwachstelle ist eine Sicherheitslücke in einem Softwaresystem, die offiziell identifiziert und der Öffentlichkeit bekannt gegeben wurde, aber von den Entwicklern der Software noch nicht behoben oder gepatcht wurde.

Während dieser Zeit bleibt die Software angreifbar und böswillige Akteure mit den entsprechenden Fähigkeiten können dies ausnutzen.

Wenn eine eintägige Schwachstelle identifiziert wird, wird sie mit dem CVE-Standard (Common Vulnerabilities and Exposures) detailliert beschrieben. Der CVE-Standard soll die Besonderheiten der Schwachstellen aufzeigen, die behoben werden müssen, aber auch die Bösewichte wissen lassen, wo die Sicherheitslücken sind.

Wir haben gezeigt, dass LLM-Agenten selbstständig Schein-Websites hacken können, aber können sie auch reale Sicherheitslücken ausnutzen?

Wir zeigen, dass GPT-4 in der Lage ist, Schwachstellen in der realen Welt auszunutzen, wo andere Modelle und Open-Source-Schwachstellen-Scanner versagen.

Papier: https://t.co/utbmMdYfmu

– Daniel Kang (@daniel_d_kang) April 16, 2024

Das Experiment

Die Forscher erstellten KI-Agenten, die auf GPT-4, GPT-3.5 und 8 anderen Open-Source-LLMs basieren.

Sie gaben den Agenten Zugang zu Tools, den CVE-Beschreibungen und der Nutzung des ReAct-Agenten-Frameworks. Das ReAct-Framework überbrückt die Lücke, damit der LLM mit anderer Software und anderen Systemen interagieren kann.

Die Forscher erstellten ein Benchmark-Set von 15 realen Ein-Tages-Schwachstellen und gaben den Agenten die Aufgabe, diese selbstständig auszunutzen.

GPT-3.5 und die Open-Source-Modelle scheiterten alle bei diesen Versuchen, aber GPT-4 nutzte 87% der Ein-Tages-Schwachstellen erfolgreich aus.

Nachdem die CVE-Beschreibung entfernt wurde, fiel die Erfolgsquote von 87 % auf 7 %. Das deutet darauf hin, dass GPT-4 Schwachstellen ausnutzen kann, wenn es die CVE-Details erhält, aber nicht sehr gut darin ist, die Schwachstellen ohne diese Anleitung zu identifizieren.

Implikationen

Cyberkriminalität und Hacking erforderten früher besondere Fähigkeiten, aber KI senkt die Messlatte. Die Forscher sagten, dass die Erstellung ihres KI-Agenten nur 91 Zeilen Code erforderte.

Mit der Weiterentwicklung von KI-Modellen werden die Fähigkeiten, die zum Ausnutzen von Cybersicherheitsschwachstellen erforderlich sind, weiter sinken. Auch die Kosten für die Skalierung dieser autonomen Angriffe werden weiter sinken.

Als die Forscher die API-Kosten für ihr Experiment zusammenrechneten, hatte ihr GPT-4-Agent 8,80 $ pro Exploit ausgegeben. Sie schätzen, dass ein Cybersecurity-Experte mit einem Stundensatz von 50 US-Dollar 25 US-Dollar pro Exploit kosten würde.

Das bedeutet, dass der Einsatz eines LLM-Agenten bereits 2,8-mal billiger ist als menschliche Arbeit und viel einfacher zu skalieren als die Suche nach menschlichen Experten. Sobald der GPT-5 und andere leistungsfähigere LLMs auf den Markt kommen, werden diese Fähigkeiten und Kostenunterschiede nur noch größer werden.

Die Forscher sagen, dass ihre Ergebnisse „die Notwendigkeit für die breitere Cybersicherheits-Community und LLM-Anbieter unterstreichen, sorgfältig darüber nachzudenken, wie LLM-Agenten in Verteidigungsmaßnahmen integriert werden können und wie ihr breiter Einsatz aussehen kann.“